Louez des serveurs GPU haute performance H100 et A100 équipés des dernières cartes graphiques Nvidia Tesla. Ces serveurs sont idéaux pour les applications exigeantes comme l’accélération IA, le traitement de larges datasets, et pour s’attaquer aux tâches complexes du calcul de haute performance (HPC). Expérimentez une vitesse et une efficacité incomparables pour vos besoins informatiques avancés.

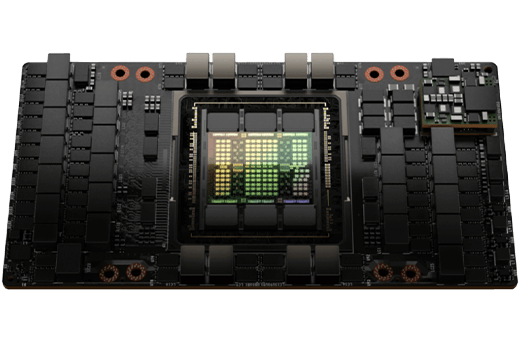

NVIDIA H100, grâce à la nouvelle architecture Hopper, est un chef d'œuvre des GPU, qui fournit une accélération IA puissante, le traitement de big data, et du calcul de haute performance (HPC).

L’architecture Hopper introduit des cœurs tensor de quatrième génération qui sont jusqu’à neuf fois plus rapides que leurs prédécesseurs, avec pour résultat une performance améliorée sur une large gamme de tâches de machine learning et de deep learning.

Avec 80GB de mémoire de grande vitesse HBM2e, ce GPU peut prendre facilement en charge de vastes modèles de langage (LLS) ou tâches IA.

La carte GPU Nvidia A100 80GB est un accélérateur de data center qui est conçu pour accélérer le training et l’inférence IA, ainsi que les applications de calcul de haute performance (HPC).

Le GPU A100 80GB dispose aussi de la plus grande capacité de mémoire et la bande passante mémoire la plus rapide de tous les GPU sur le marché. Cela le rend idéal pour le training et le déploiement des modèles IA les plus vastes, ainsi que pour l’accélération d’applications de HPC qui nécessitent des datasets importants.

Le GPU H100 est l’accélérateur le plus puissant jamais construit, avec une performance jusqu’à 4 fois plus rapide pour le training IA, et 7 fois plus rapide pour les applications HPC, par rapport à la génération précédente.

L’architecture H100 est suralimentée pour les charges de travail les plus importantes, depuis les grands modèles de langage jusqu’aux applications de calcul scientifique. Elle est aussi hautement modulable, prenant en charge jusqu’à 18 interconnexions NVLink pour une communication à large bande passante entre les GPU.

Le GPU H100 est conçu pour une utilisation par les entreprises, avec des fonctionnalités telles que la prise en charge de PCIe Gen5, un réseau NDR Quantum-2 InfiniBand, et un logiciel NVIDIA Magnum IO pour une modulabilité efficace.

Ces coeurs sont spécifiquement conçus pour accélérer les charges de travail IA, et offrent des performances jusqu’à 2 fois plus rapides pour la précision FP8, par rapport à la génération précédente

Cette fonctionnalité permet au GPU A100 de passer outre les portions inutilisées d’une matrice, ce qui peut améliorer la performance jusqu’à x2 pour certaines charges de travail IA.

Cette fonctionnalité permet au GPU A100 d’être divisé en sept (au maximum) instances GPU plus petites, qui peuvent être utilisées pour accélérer de multiples charges de travail simultanément.

Voici plusieurs comparateurs pour les GPU Nvidia A100 80GB et H100, vis à vis d’autres GPU pour IA et HPC :

Comparateur IA |

||||

| Comparateur | A100 80GB | H100 | A40 | V100 |

| ResNet-50 Inference (Images/s) | 13 128 | 24 576 | 6 756 | 3 391 |

| BERT Large Training (Steps/s) | 1 123 | 2 231 | 561 | 279 |

| GPT-3 Training (Tokens/s) : | 175B | 400B | 87.5B | 43.75B |

Comparateur HPC |

||||

| Comparateur | A100 80GB | H100 | A40 | V100 |

| HPL DP (TFLOPS) | 40 | 90 | 20 | 10 |

| HPCG (GFLOPS) | 45 | 100 | 22.5 | 11.25 |

| LAMMPS (Atoms/day) : | 115T | 250T | 57,5T | 28,75T |

Le GPU Nvidia H100 est considérablement plus rapide que le GPU A100 qu’il s’agisse d’IA ou de HPC. Il est aussi plus rapide que d’autres GPU comme le A40 et le V100. Cependant, le GPU Nvidia A100 est moins onéreux et pourrait être plus rentable pour des tâches importantes en matière d'IA et de calcul de HPC.

| H100 pour les Serveurs PCIe | A100 80GB PCIe | |

| FP64 | 26 teraFLOPS | 9.7 TFLOPS |

| FP64 Tensor Core | 51 teraFLOPS | 19.5 TFLOPS |

| FP32 | 51 teraFLOPS | 19.5 TFLOPS |

| TF32 Tensor Core | 756 teraFLOPS | 156 TFLOPS | 312 TFLOPS |

| BFLOAT16 Tensor Core | 1,513 teraFLOPS | 312 TFLOPS | 624 TFLOPS |

| FP16 Tensor Core | 1,513 teraFLOPS | 312 TFLOPS | 624 TFLOPS |

| FP8 Tensor Core | 3,026 teraFLOPS | |

| INT8 Tensor Core | 3,026 TOPS | 624 TOPS | 1248 TOPS |

| Mémoire GPU | 80GB | 80GB HBM2e |

| Bande passante mémoire GPU | 2TB/s | 1,935 GB/s |

| Décodeurs |

7 NVDEC 7 JPEG |

|

| Enveloppe thermique (TDP) maximum | 300-350W (configurable) | 300W |

| GPU multi instances | Jusqu’à 7 MIGS @ 10GB chacun | Jusqu’à 7 MIGs @ 10GB |

| Facteur de forme | PCIe refroidissement à air dual-slot |

PCIe refroidissement à air dual-slot ou refroidissement liquide single-slot |

| Interconnexion | NVLink: 600GB/s PCIe Gen5: 128GB/s |

NVIDIA® NVLink® Bridge for 2 GPUs: 600 GB/s PCIe Gen4: 64 GB/s |

| Options serveur | Systèmes certifiés Partner and NVIDIA™ avec 1-8 GPUs | Systèmes certifiés Partner and NVIDIA™ avec 1-8 GPUs |

| NVIDIA AI Enterprise | Inclus |

Contactez notre service des ventes pour revoir les conditions générales de vente et d’utilisation avant de passer commande de serveurs GPU équipés de cartes Nvidia Tesla H100 ou A100.

Nos services

Serveurs GPU pour data science

Hébergement e-Commerce

Finance et FinTech

Cloud privé

Rendering, Design 3D et visualisation

Colocation managée

Large gamme de serveurs préconfigurés avec livraison instantanée et promotion

Vous avez besoin d’informations supplémentaires ou vous avez des questions ?