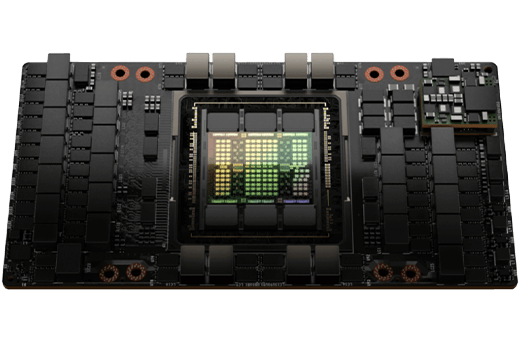

NVIDIA H100,采用新的Hopper架构,是一款强大的GPU,提供强大的AI加速、大数据处理和高性能计算(HPC)能力。

Hopper架构引入了第四代张量核心,与前代相比,速度提升了九倍,从而在各种机器学习和深度学习任务中提升了性能。

配备80GB高速HBM2e内存的这款GPU可以轻松处理大型语言模型(LLM)或AI任务。

Nvidia A100 80GB GPU卡是一款数据中心加速器,专为加速AI训练和推理以及高性能计算(HPC)应用而设计。

A100 80GB GPU还具有市场上任何GPU中最大的内存容量和最快的内存带宽。这使其非常适合训练和部署最大的AI模型,以及加速需要大数据集的HPC应用。

H100 GPU是有史以来构建的最强大的加速器,其AI训练的性能比上一代快4倍,HPC应用的性能快7倍。

H100的架构针对最大的工作负载进行了超级加速,从大型语言模型到科学计算应用都能应对。它还具有高度可扩展性,支持多达18个NVLink互连,以实现GPU之间的高带宽通信。

H100 GPU专为企业使用设计,具备支持PCIe Gen5、NDR Quantum-2 InfiniBand网络和NVIDIA Magnum IO软件等特性,以实现高效的可扩展性。

这些核心专门设计用于加速AI工作负载,它们提供的FP8精度性能比上一代快2倍。

T这一特性允许A100 GPU跳过矩阵中未使用的部分,这可以使某些AI工作负载的性能提高高达2倍。

这一功能允许A100 GPU被分割成多达七个较小的GPU实例,这些实例可以用来同时加速多个工作负载。

以下是Nvidia A100 80GB和H100 GPU与其他GPU在AI和HPC方面的一些基准测试比较:

人工智能基准 |

||||

| 基准 | A100 80GB | H100 | A40 | V100 |

| ResNet-50推理(图像/秒) | 13 128 | 24 576 | 6 756 | 3 391 |

| BERT大型训练(步数/秒) | 1 123 | 2 231 | 561 | 279 |

| GPT-3培训(代币/秒) | 175b | 400b | 87.5b | 43.75b |

HPC基准 |

||||

| 基准 | A100 80GB | H100 | A40 | V100 |

| HPL DP (TFLOPS) | 40 | 90 | 20 | 10 |

| HPCG (GFLOPS) | 45 | 100 | 22.5 | 11.25 |

| LAMMPS(原子/天) | 115t | 250t | 57.5t | 28.75t |

Nvidia H100 GPU在AI和HPC基准测试中的性能显著超过A100 GPU,并且也比其他GPU更快,如A40和V100。但是,Nvidia A100 GPU的价格更低,对于重要的AI和HPC任务来说可能更具成本效益。

| 用于基于PCIe服务器的H100 | A100 80GB PCIe | |

| FP64 | 26 teraFLOPS | 9.7 TFLOPS |

| FP64张量核心 | 51 teraFLOPS | 19.5 TFLOPS |

| FP32 | 51 teraFLOPS | 19.5 TFLOPS |

| TF32张量核心 | 756 teraFLOPS | 156 TFLOPS | 312 TFLOPS |

| BFLOAT16张量核心 | 1,513 teraFLOPS | 312 TFLOPS | 624 TFLOPS |

| FP16 张量核心 | 1,513 teraFLOPS | 312 TFLOPS | 624 TFLOPS |

| FP8张量核心 | 3,026 teraFLOPS | |

| INT8张量核心 | 3,026 TOPS | 624 TOPS | 1248 TOPS |

| GPU内存 | 80GB | 80GB HBM2e |

| GPU内存带宽 | 2TB/s | 1,935 GB/s |

| 解码器 |

7 NVDEC 7 JPEG |

|

| 最大热设计功率(TDP) | 300-350W (可配置) | 300W |

| 多实例GPU | 最多 7 个 MIGS,每个 10GB | 最多 7 个 MIG,每个 10GB |

| 尺寸规格 | PCIe 双槽风冷 |

PCIe 双槽风冷或单槽液冷 |

| 互联 | NVLink: 600GB/s PCIe Gen5: 128GB/s |

NVIDIA® NVLink® Bridge for 2 GPUs: 600 GB/s PCIe Gen4: 64 GB/s |

| 服务器配置 | Partner and NVIDIA-Certified Systems with 1–8 GPUs | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs |

| NVIDIA AI Enterprise | 包括 |

在订购配备Nvidia Tesla H100或A100显卡的GPU服务器之前,请联系我们的销售部门,以了解相关条款和条件。

我们的服务

用于数据科学的GPU服务器

电子商务托管

金融与金融科技

私有云

渲染、3D设计与可视化

受监督的托管

用于深度学习的 GPU 服务器

提供即时交付和销售的多种预配置服务器

如果您没有找到合适的配置,可以随时联系我们的销售部门。我们的经理将帮助满足您的需求。我们非常灵活。

如果没找到合适配置,可以随时联系我们的 销售部门。我们的经理将帮助满足您的需求。我们非常灵活。

您可以在荷兰、德国、芬兰、冰岛、土耳其和美国选择合适的数据中心。

我们对每位客户采用个性化方法,这体现在技术方案和数据中心选择上。我们提供 TIER III 数据中心,为每位客户提供最灵活的解决方案。

对于关键业务应用,可用性至关重要。这种情况下,您至少需要 Tier III 认证数据中心。次要任务可选 TIER II 或 TIER I 数据中心。

完整数据中心列表及特性可在此查看。

如果可用性对您至关重要,我们推荐认证数据中心,如 EuNetworks。

您可以使用试用期测试服务器。需预付 1 个月费用。如不满意可随时取消,扣除已用金额后余额可用于其他 HOSTKEY 服务。注意:需要购买许可证(如 Windows)的服务器不提供按小时付费选项,最短租期为 1 个月。

我们的所有服务都需要预付。我们接受以下支付方: 信用卡PayPal通过 BitPay 进行的 P2P 加密货币支付(支持任何钱包、应用程序或交易所)WebMoney 支付宝银行转账 了解更多关于我们的支付条款和方法的信息。

我们对自己的产品和服务非常有信心。我们提供快速、可靠和全面的服务,相信您会完全满意。

您可以申请免费使用测试服务器 3-4 天。

只有在我们方面出现事故,导致您的服务器因此而离线 24 小时或更长时间时,才可能退款。

了解更多关于退款程序的信息。

对于带有无限带宽的服务器,客户需遵守合理使用政策。

这意味着使用 1 Gbps 端口的服务器,每天不能超过 3 小时使用超过分配带宽的 70%。